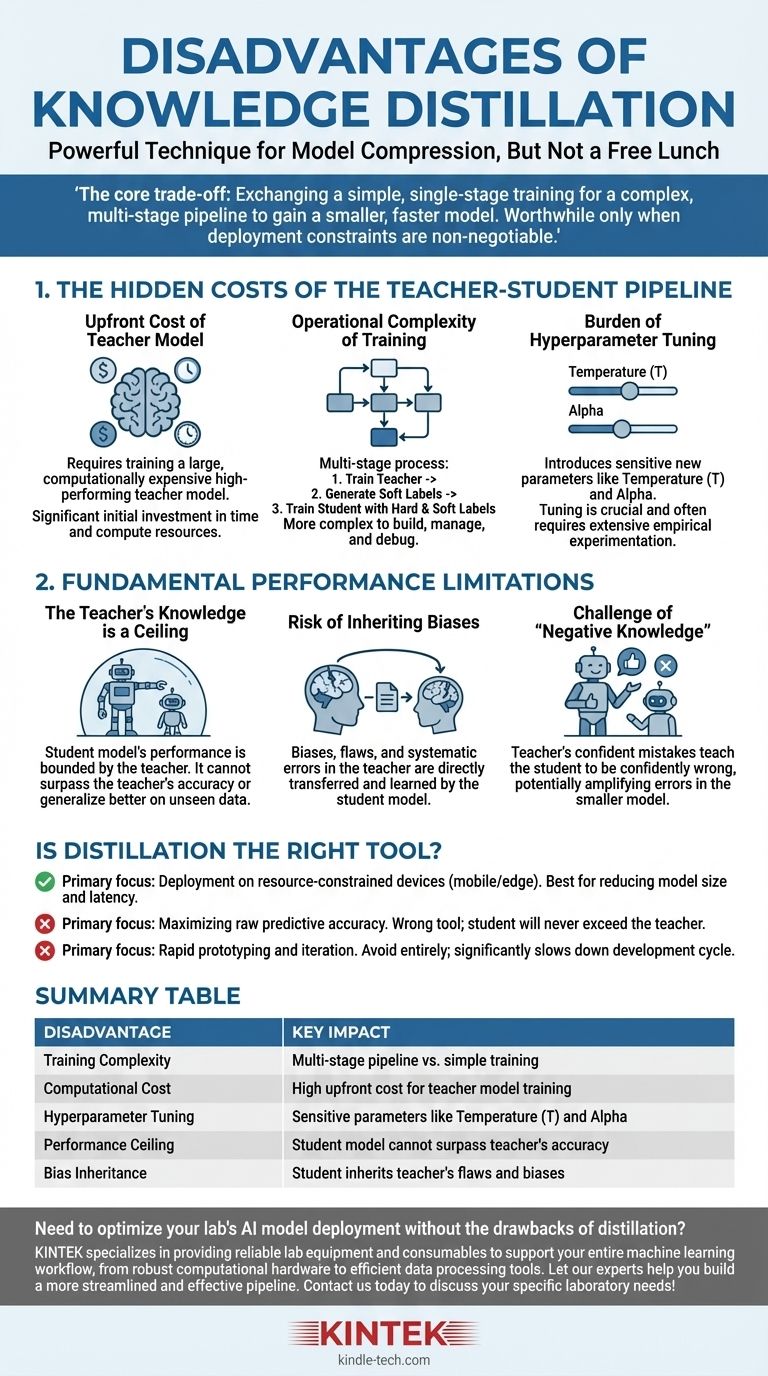

Bien que la distillation des connaissances soit une technique puissante pour la compression de modèles, ce n'est pas une solution miracle. Les principaux inconvénients sont l'augmentation significative de la complexité de l'entraînement et du coût de calcul, l'introduction de nouveaux hyperparamètres sensibles, et le plafond de performance rigide imposé par la qualité du modèle enseignant.

Le compromis fondamental de la distillation est clair : vous échangez un processus d'entraînement plus simple, en une seule étape, contre un pipeline complexe, en plusieurs étapes, pour obtenir un modèle plus petit et plus rapide. Cet investissement en complexité ne vaut la peine que lorsque les contraintes de déploiement, telles que la latence ou la mémoire, sont non négociables.

Les coûts cachés du pipeline Enseignant-Élève

Les inconvénients les plus immédiats de la distillation ne sont pas conceptuels mais pratiques. Ils impliquent le temps, les ressources et l'effort d'ingénierie supplémentaires nécessaires pour gérer un flux de travail d'entraînement plus complexe.

Le coût initial du modèle enseignant

Avant même de pouvoir commencer la distillation, vous avez besoin d'un modèle enseignant performant. Ce modèle est, par conception, grand et coûteux en calcul à entraîner.

Cette phase d'entraînement initiale représente un coût significatif et non négligeable en temps et en ressources de calcul qui doit être payé avant que l'entraînement "réel" du modèle élève ne puisse commencer.

La complexité opérationnelle de l'entraînement

La distillation est un processus en plusieurs étapes, contrairement à l'entraînement de modèle standard. Le flux de travail typique est le suivant :

- Entraîner le grand modèle enseignant jusqu'à convergence.

- Effectuer l'inférence avec le modèle enseignant sur l'ensemble de votre jeu de données d'entraînement pour générer les "étiquettes douces" ou les logits.

- Entraîner le modèle élève plus petit en utilisant à la fois les "étiquettes dures" originales et les étiquettes douces de l'enseignant.

Ce pipeline est intrinsèquement plus complexe à construire, à gérer et à déboguer qu'un script d'entraînement standard.

Le fardeau de l'ajustement des hyperparamètres

La distillation introduit des hyperparamètres uniques qui régissent le processus de transfert de connaissances, et ils nécessitent un ajustement minutieux.

Le plus critique est la température (T), une valeur utilisée pour adoucir la distribution de probabilité des sorties de l'enseignant. Une température plus élevée révèle des informations plus nuancées sur le "raisonnement" de l'enseignant, mais trouver la valeur optimale est un processus empirique.

Un autre hyperparamètre clé est alpha, qui équilibre la perte des étiquettes douces de l'enseignant par rapport à la perte des étiquettes dures de vérité terrain. Cet équilibre est crucial pour le succès et nécessite souvent une expérimentation approfondie.

Les limitations fondamentales de performance

Au-delà des coûts pratiques, la distillation présente des limitations inhérentes qui plafonnent le potentiel du modèle élève final.

La connaissance de l'enseignant est un plafond

La performance d'un modèle élève est fondamentalement limitée par la connaissance de son enseignant. L'élève apprend à imiter la distribution de sortie de l'enseignant.

Par conséquent, l'élève ne peut pas surpasser l'enseignant en précision ni mieux généraliser sur des données non vues. Il ne peut qu'espérer devenir une approximation très efficace des capacités de l'enseignant.

Le risque d'hériter des biais

Tout biais, défaut ou erreur systématique présent dans le modèle enseignant sera directement transféré et appris par le modèle élève.

La distillation ne "nettoie" pas la connaissance ; elle la transfère simplement. Si l'enseignant a un biais contre une certaine démographie ou une faiblesse dans un domaine de données spécifique, l'élève héritera de cette même faiblesse.

Le défi de la "connaissance négative"

Si le modèle enseignant est confiant à tort concernant une prédiction spécifique, il apprendra à l'élève à être confiant à tort également.

Ceci est potentiellement plus nuisible qu'un modèle simplement incertain. Le processus de distillation peut amplifier les erreurs de l'enseignant, les intégrant dans le modèle plus petit et plus efficace où elles peuvent être plus difficiles à détecter.

La distillation est-elle le bon outil pour votre objectif ?

En fin de compte, la décision d'utiliser la distillation dépend entièrement de l'objectif principal de votre projet.

- Si votre objectif principal est le déploiement sur des environnements à ressources contraintes (comme les appareils mobiles ou périphériques) : La distillation est une technique de pointe pour atteindre la réduction nécessaire de la taille du modèle et de la latence, à condition que vous puissiez vous permettre la complexité d'entraînement initiale.

- Si votre objectif principal est de maximiser la précision prédictive brute : La distillation est le mauvais outil. Votre effort serait mieux dépensé à entraîner le meilleur modèle autonome possible, car l'élève ne dépassera jamais les performances de l'enseignant.

- Si votre objectif principal est le prototypage rapide et l'itération : Évitez complètement la distillation. Le pipeline en plusieurs étapes et l'ajustement complexe des hyperparamètres ralentiront considérablement votre cycle de développement et d'expérimentation.

Comprendre ces inconvénients vous permet de déployer la distillation des connaissances de manière stratégique, en la reconnaissant comme un outil spécialisé pour l'optimisation, et non comme une méthode universelle d'amélioration.

Tableau récapitulatif :

| Inconvénient | Impact clé |

|---|---|

| Complexité de l'entraînement | Pipeline multi-étapes vs. entraînement simple |

| Coût de calcul | Coût initial élevé pour l'entraînement du modèle enseignant |

| Ajustement des hyperparamètres | Paramètres sensibles comme la température (T) et alpha |

| Plafond de performance | Le modèle élève ne peut pas surpasser la précision de l'enseignant |

| Héritage des biais | L'élève hérite des défauts et des biais de l'enseignant |

Besoin d'optimiser le déploiement des modèles d'IA de votre laboratoire sans les inconvénients de la distillation ? KINTEK est spécialisé dans la fourniture d'équipements et de consommables de laboratoire fiables pour soutenir l'ensemble de votre flux de travail d'apprentissage automatique, du matériel informatique robuste aux outils de traitement de données efficaces. Laissez nos experts vous aider à construire un pipeline plus rationalisé et efficace. Contactez-nous dès aujourd'hui pour discuter de vos besoins spécifiques en laboratoire !

Guide Visuel

Produits associés

Les gens demandent aussi

- Quelle est la règle du delta 20 pour l'évaporation ? Maîtriser la pulvérisation sûre et efficace

- Quels facteurs affectent l'évaporation et la condensation ? Maîtrisez la science des changements de phase de l'eau

- Quelle est la différence entre l'extrait de cannabis et le distillat ? Un guide sur la puissance par rapport aux effets à spectre complet.

- Qu'est-ce que la règle Delta 20 ? Un guide pour diagnostiquer et perfectionner votre expresso

- Le distillat de THC perd-il de sa puissance ? Un guide pour préserver la puissance de votre produit.